C’est la méthode la plus utilisée pour l’imputation des données manquantes pour les variables catégorielles. Cette méthode consiste à traiter les données manquantes comme une étiquette ou une catégorie supplémentaire de la variable. Toutes les observations manquantes sont regroupées dans la nouvelle étiquette “manquante”.

Il s’agit essentiellement de l’équivalent du remplacement par une valeur arbitraire pour les variables numériques.

La beauté de cette technique réside dans le fait qu’elle ne suppose rien sur le fait que les données sont manquantes. Elle est très bien adaptée lorsque le nombre de données manquantes est élevé.

Avantages

- Facile à mettre en œuvre

- Moyen rapide d’obtenir des ensembles de données complets

- Peut être intégré dans la production (lors du déploiement du modèle)

- Saisit l’importance du “manque” s’il y en a un

- Aucune supposition faite sur les données

Limitations

- Si le nombre de NA est faible, la création d’une catégorie supplémentaire peut entraîner un surdimensionnement des arbres

Pour les variables catégorielles, c’est la méthode de choix, car elle traite les valeurs manquantes comme une catégorie distincte, sans faire d’hypothèse sur la variable ou les raisons pour lesquelles les données pourraient être manquantes. Elle est largement utilisée dans les concours et les organisations de science des données.

En remplaçant NA dans les variables catégorielles par une étiquette appelée “manquante”, nous n’apprenons rien de l’ensemble de formation, donc en principe nous pourrions faire cela dans l’ensemble de données original et ensuite séparer en train et test. Cependant, je ne recommande pas cette pratique. Vous verrez dans les prochains cahiers que la séparation en train et test dès le début aide à construire un pipeline d’apprentissage machine. Je vais donc continuer à appliquer cette pratique ici aussi.

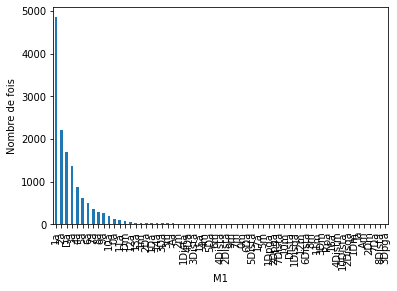

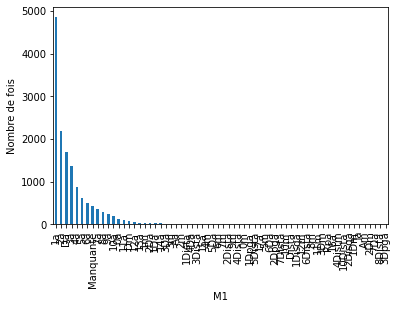

M1

Nous voyons notre nouvelle étiquette manquante

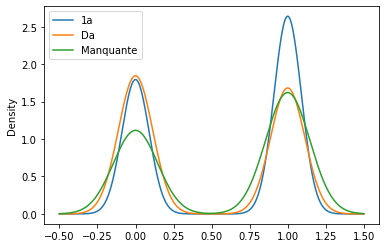

On voit que l’étiquette Manquante est globalement plus présente à l’arrivée de Da

Je télécharge mon guide gratuit

Thank you!

You have successfully joined our subscriber list.

Vous recevrez votre guide par email sans aucun engagement de votre part.