Imputation la plus fréquente par catégorie | Imputation par mode

L’imputation consiste à remplacer les données manquantes par des estimations statistiques des valeurs manquantes. L’objectif de toute technique d’imputation est de produire un ensemble complet de données qui peut être utilisé pour former des modèles d’apprentissage automatique.

L’imputation par mode consiste à remplacer toutes les occurrences de valeurs manquantes (NA) au sein d’une variable par le mode, qui en d’autres termes se réfère à la valeur la plus fréquente ou à la catégorie la plus fréquente.

Quelles variables puis-je imputer avec l’imputation la plus fréquente / mode ?

Bien que le mode, ou la valeur la plus fréquente, puisse être calculé pour les variables numériques et catégorielles, en pratique, nous n’utilisons cette technique que pour les variables catégorielles. La raison en est que pour les variables numériques, la moyenne ou la médiane a tendance à mieux représenter la valeur moyenne de la population.

Hypothèses

- Les données sont complètement manquantes au hasard (MCAR)

- Les observations manquantes, ressemblent très probablement à la majorité des observations de la variable (aka, le mode)

Le raisonnement est que la valeur qui aurait dû être observée pour l’observation manquante est très probablement la valeur ou la catégorie la plus fréquente de la variable.

Avantages

- Facile à mettre en œuvre

- Moyen rapide d’obtenir des ensembles de données complets

- Peut être intégré dans la production (lors du déploiement du modèle)

Limitations

- Distorsion de la relation de l’étiquette la plus fréquente avec d’autres variables de l’ensemble de données

- Peut conduire à une surreprésentation du label le plus fréquent s’il y a un grand nombre de NA

Quand utiliser le mode / l’imputation par catégorie la plus fréquente ?

- Les données sont complètement manquantes au hasard

- Pas plus de 5 % de la variable contient des données manquantes

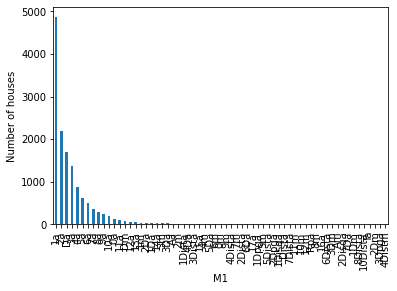

La variable M1 ne contient que quelques observations avec NA (2,9), c’est pourquoi le remplacement de ces observations par la valeur de la catégorie la plus fréquente est une bonne approche.

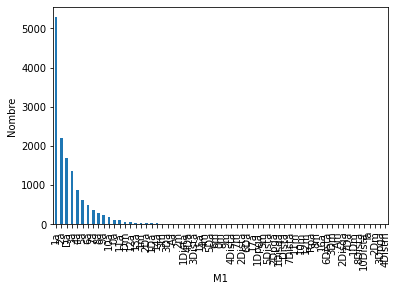

La variable idHippodrome ne contient que quelques observations avec NA (5,9), c’est pourquoi le remplacement de ces observations par la valeur de la catégorie la plus fréquente est une bonne approche.

Imputation importante

L’imputation doit être faite sur l’ensemble de formation, puis propagée à l’ensemble de test. Cela signifie que la catégorie la plus fréquente doit être sélectionnée dans l’ensemble d’entraînement et utilisée pour remplacer NA dans les ensembles d’entraînement et de test.

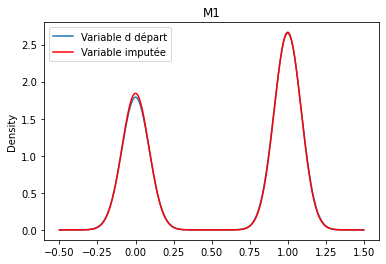

M1

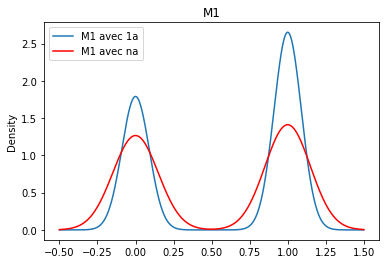

Le graphique ci-dessus indique que M1 pour lesquelles les données sont manquantes globalement se positionnent moins en placé.

Nous pouvons voir que la catégorie 1a est désormais plus présente.